Einem „Roboterhund“ wurden menschenähnliche Wahrnehmungsfähigkeiten verliehen

Der Roboter WildFusion kann nicht nur wie die meisten Roboter sehen, sondern auch Vibrationen, Berührungen und "Körperzustände" wahrnehmen, um den Wald zu erkunden, ähnlich wie ein Tier.

Manchmal wird leicht übersehen, wie viel unsere Sinne für uns tun. Sie ermöglichen es uns, uns in einer komplexen Welt zurechtzufinden, die in der Wildnis immer vielfältiger wird.

Gehör, Geruch, Tastsinn und Gleichgewichtssinn helfen uns, uns in der Landschaft zurechtzufinden, sei es bei einem morgendlichen Lauf oder einer Bergwanderung.

Der Blick auf Details, die wir vielleicht nicht einmal bewusst wahrnehmen, kann uns bei der Orientierung helfen, z. B. das Blätterdach der Bäume über uns oder die Veränderung von Schatten und Farben in der Ferne, die auf neues Terrain hinweisen, oder sogar die Anwesenheit von Wasser.

Wenn wir das Moos unter unseren Füßen oder das Knacken von Ästen spüren, erfahren wir nicht nur etwas über das sich verändernde Terrain, sondern auch über unsere eigene Stabilität. Dies kann auch durch das Wetter wahrgenommen werden. Eine veränderte Farbe des Himmels oder eine Temperaturveränderung warnt unseren Instinkt vor einem möglichen Sturm. Ein drohendes Gewitter warnt vor der Gefahr.

Aber ist ein Roboter blind für diese Details? Sie haben nicht die Wahrnehmungsfähigkeiten von Tieren oder uns Menschen. Oder doch? Vielleicht werden sie es, dank neuer Innovationen. WildFusion, zeigt eine solche Möglichkeit.

Treffen Sie WildFusion

Roboter waren lange Zeit ausschließlich auf visuelle Daten wie Kameras oder Lidar angewiesen, um sich in der Welt zu bewegen.

Die multisensorische Navigation stellt für Roboter eine Herausforderung dar - vor allem im Wald, der für typische Roboter, die sich auf Kamerasichttechnologie verlassen, ein Reich der Unsicherheit ist.

Were thrilled to share our new research WildFusion: Multimodal Implicit 3D Reconstructions in the Wild.

— Boyuan Chen (@Boyuan__Chen) October 13, 2024

Our robot doesnt just see with LiDAR and camerasit feels, hears, and learns using tactile sensors, IMU data, and contact microphones. Combining these signals creates pic.twitter.com/A2vmmJ192d

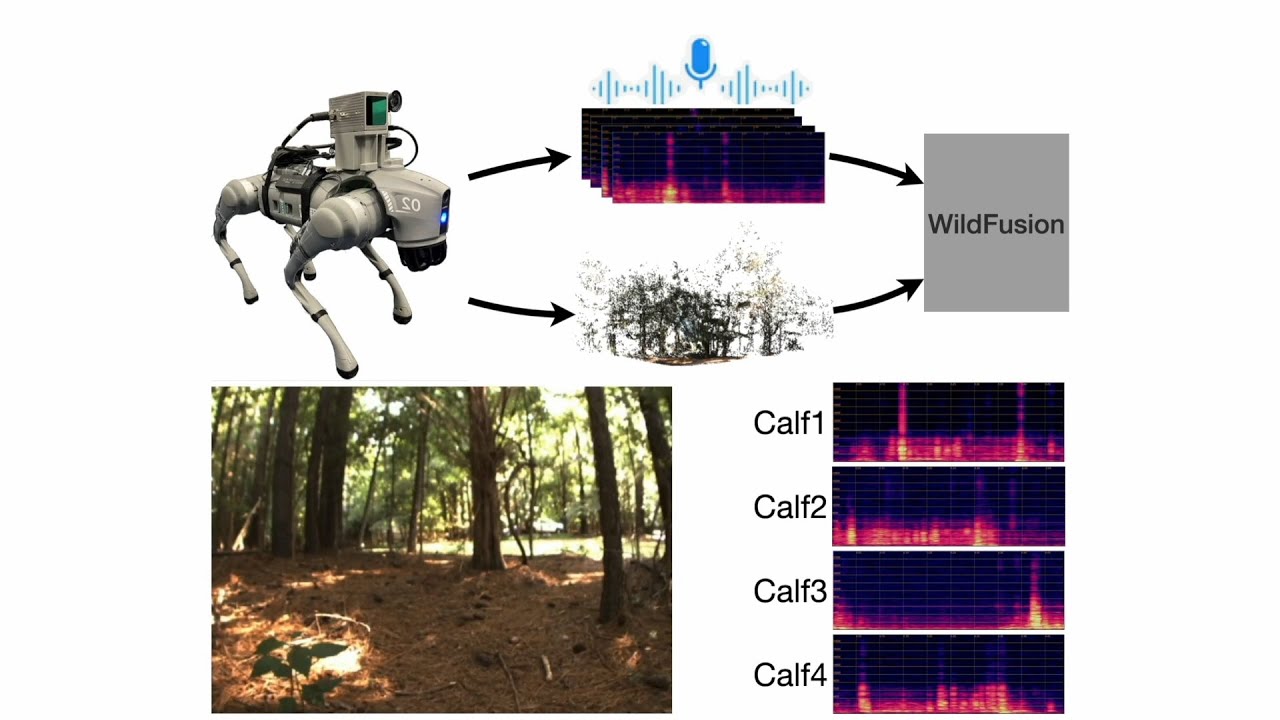

Experten der Duke University haben WildFusionentwickelt , das nicht nur das Sehvermögen, sondern auch Vibrationen und Berührungen nutzt, um dem Roboter zu ermöglichen, komplexe Umgebungen im Freien wie ein Mensch zu erkennen.

"WildFusion schlägt ein neues Kapitel in der Roboternavigation und 3D-Kartierung auf", sagt Boyuan Chen, Assistenzprofessor an der Duke University. "Es hilft Robotern, in unstrukturierten, unvorhersehbaren Umgebungen wie Wäldern, Katastrophengebieten und im Gelände sicherer zu operieren."

"Typische Roboter verlassen sich stark auf Vision oder LiDAR allein, die ohne klare Pfade oder vorhersehbare Orientierungspunkte oft ins Stocken geraten", fügte Yanbaihui Liu hinzu, der Hauptautor der Studie , der in Chens Labor promoviert .

"Selbst fortschrittliche 3D-Kartierungsmethoden haben Schwierigkeiten, eine kontinuierliche Karte zu rekonstruieren, wenn die Sensordaten spärlich, verrauscht oder unvollständig sind, was ein häufiges Problem in unstrukturierten Außenumgebungen ist. Das ist genau die Herausforderung, für die WildFusion entwickelt wurde."

Wie sieht WildFusion aus?

In gewisser Weise sieht der WildFusion-Roboter wie ein Hund aus, weil er auf vier Beinen steht - er ist vierbeinig. Er nutzt mehrere Sensormodalitäten: Trägheitssensoren, taktile Sensoren, Kontaktmikrofone, LiDAR und eine RGB-Kamera.

Kontaktmikrofone können die verschiedenen Vibrationen bei jedem Schritt seiner Beine erfassen. Selbst kleine Unterschiede wie das Knirschen von trockenem Laub oder das Matschen von Schlamm können wahrgenommen werden. Diese taktilen Sensoren können erkennen, wie viel Kraft auf jeden Fuß ausgeübt wird. Dies hilft dem Roboter, Stabilität oder rutschige Oberflächen zu erkennen - alles in Echtzeit.

Die Beschleunigungsdaten geben Aufschluss darüber, wie stark der Roboter auf unebenem Boden wackelt oder rollt. Das "Herzstück" von WildFusion ist ein Deep-Learning-Modell, das all diese Sensorfähigkeiten in Einklang bringt - ähnlich wie das menschliche Gehirn.

Dadurch kann der Roboter dank intelligenter Entscheidungen , die für einen Menschen als "intuitiv" gelten würden, flüssige Bewegungen über komplexes Gelände ausführen.

"Stellen Sie sich vor, Sie lösen ein Puzzle, bei dem einige Teile fehlen, aber Sie sind in der Lage, sich intuitiv das vollständige Bild vorzustellen", erklärte Chen. "Der multimodale Ansatz von WildFusion ermöglicht es dem Roboter, die Lücken zu füllen, wenn die Sensordaten spärlich oder verrauscht sind, ähnlich wie es der Mensch tut".

Interne Mechanik

Der Roboter wurde in einem Park in North Carolina in der Nähe des Campusgeländes der Duke University getestet , wobei er sich über Waldgelände, Wiesen und Schotter bewegte.

Zu sehen, wie der Roboter sicher durch das Gelände navigiert, war unglaublich befriedigend", so Liu. "Diese realen Tests haben die bemerkenswerte Fähigkeit von WildFusion bewiesen, die Durchquerbarkeit genau vorherzusagen, was die Entscheidungsfindung des Roboters in Bezug auf sichere Wege durch schwieriges Gelände erheblich verbessert hat.

Potenzial für Verteidigung

Das System kann mit noch mehr Sensoren, z. B. zur Erkennung von Feuchtigkeit, weiterentwickelt werden, damit der Roboter komplexe Umgebungen verstehen und sich an sie anpassen kann. Dies wird es WildFusion ermöglichen, über den Wald hinaus auch in abgelegene Infrastrukturen, Katastrophengebiete und Bereiche der autonomen Erforschung vorzudringen.

"Eine der größten Herausforderungen für die Robotik besteht heute darin, Systeme zu entwickeln, die nicht nur im Labor gut funktionieren, sondern auch in der realen Welt zuverlässig funktionieren", so Chen. "Das bedeutet, dass Roboter sich anpassen, Entscheidungen treffen und in Bewegung bleiben können, auch wenn die Welt unübersichtlich wird."

Im Moment scheint es ein echtes Interesse und Potenzial für diese Robotertechnologien im Verteidigungsbereich zu geben. Diese Arbeit wurde von der Defense Advanced Research Projects Agency, Army Research Laboratory, finanziert.

Die Arbeit wird auf der prestigeträchtigen IEEE International Conference on Robotics and Automation (ICRA 2025) vorgestellt , die noch bis zum 23. Mai 2025 in Atlanta, Georgia, stattfindet.

Quellenhinweis:

Empowering Robots with Human-Like Perception to Navigate Unwieldy Terrain / WildFusion: Multimodal Implicit 3D Reconstructions in the Wild. Duke University. Reports and Proceedings. May 2025.

WildFusion: Multimodal Implicit 3D Reconstructions in the Wild. International Conference on Robotics and Automation (ICRA 2025). Conference teaser. Sept 2024.